-

Serviços

- Áreas de Prática

-

Setores

- Agribusiness

- Banca e Instituições Financeiras

- Desporto

- Distribuição e Retalho

- Economia Social

- Educação

- Energia e Recursos Naturais

- Governo e Setor Público

- Imobiliário e Construção

- Infraestruturas

- Mobilidade, Transportes e Logística

- Produção Industrial

- Saúde, Ciências da Vida e Farmacêutico

- Seguros e Fundos de Pensões

- Turismo e Lazer

- Desks

- Buzz Legal

-

Pessoas

-

As nossas pessoas

Meticulosos com o que é. Inconformistas com o que pode vir a ser.

Conheça a equipa

-

-

Conhecimento

-

Subscrever newsletterMantenha-se Informado

Subscreva a newsletter PLMJ para receber informação, alertas e novidades sobre as suas áreas e setores de interesse.

-

-

Sobre nós

-

Candidate-seInvestimos em talento

Procuramos pessoas que vão mais longe, que enfrentam o futuro com confiança.

-

- ESG

-

Serviços

- Áreas de Prática

-

Setores

- Agribusiness

- Banca e Instituições Financeiras

- Desporto

- Distribuição e Retalho

- Economia Social

- Educação

- Energia e Recursos Naturais

- Governo e Setor Público

- Imobiliário e Construção

- Infraestruturas

- Mobilidade, Transportes e Logística

- Produção Industrial

- Saúde, Ciências da Vida e Farmacêutico

- Seguros e Fundos de Pensões

- Turismo e Lazer

- Desks

- Buzz Legal

-

Pessoas

-

As nossas pessoas

Meticulosos com o que é. Inconformistas com o que pode vir a ser.

Conheça a equipa

-

-

Conhecimento

-

Subscrever newsletterMantenha-se Informado

Subscreva a newsletter PLMJ para receber informação, alertas e novidades sobre as suas áreas e setores de interesse.

-

-

Sobre nós

-

Candidate-seInvestimos em talento

Procuramos pessoas que vão mais longe, que enfrentam o futuro com confiança.

-

- ESG

Nota Informativa

AI Act: Orientações da Comissão sobre sistemas de risco elevado

20/06/2025A Comissão Europeia lançou recentemente uma consulta pública sobre as Orientações a considerar na classificação de sistemas de Inteligência Artificial (IA) de risco elevado. O objetivo da consulta é a recolha de contributos sobre:

A Comissão Europeia lançou recentemente uma consulta pública sobre as Orientações a considerar na classificação de sistemas de Inteligência Artificial (IA) de risco elevado.

Classificação de Sistemas de IA de risco elevado

- Exemplos práticos de sistemas de IA que podem ser classificados como de risco elevado;

- Questões sobre as regras de classificação de sistemas de IA de risco elevado nos termos previstos no artigo 6.º e anexos I e III do Regulamento da Inteligência Artificial [1] (AI Act)

Proposta de orientações da Comissão relativas ao artigo 6.º do AI Act (Orientações)

- Questões a esclarecer nas Orientações a emitir pela Comissão sobre a classificação de sistemas de IA de risco elevado.

- Futuras directrizes sobre requisitos e obrigações que os sistemas de IA de risco elevado devem cumprir.

- Definição clara das responsabilidades de prestadores, implementadores e outros interveniente ao longo da cadeia de valor da IA

CLASSIFICAÇÃO DE SISTEMAS NO AI ACT

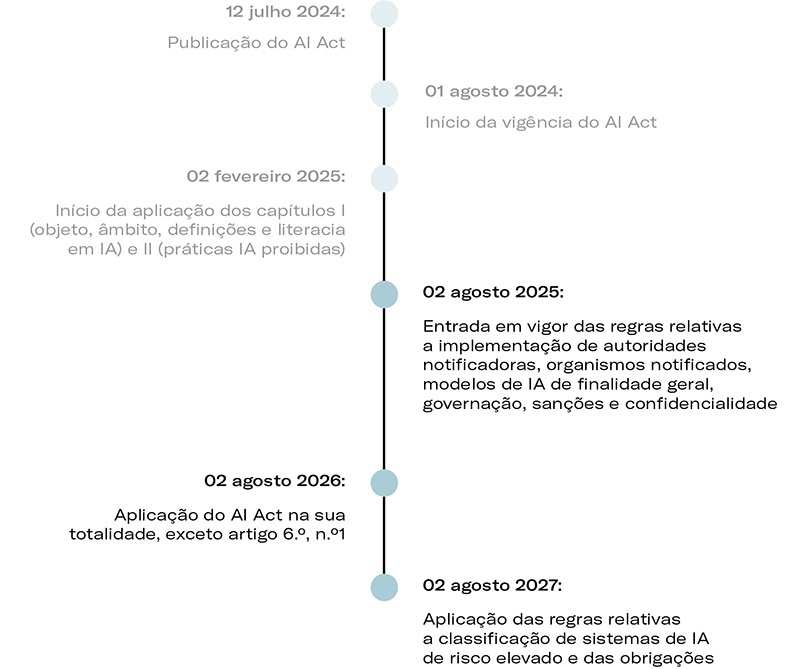

O AI Act entrou em vigor a 1 de agosto de 2024 para estabelecer regras harmonizadas visando o uso de sistemas de inteligência artificial coerentes, de confiança e eticamente corretos (centrados no ser humano).

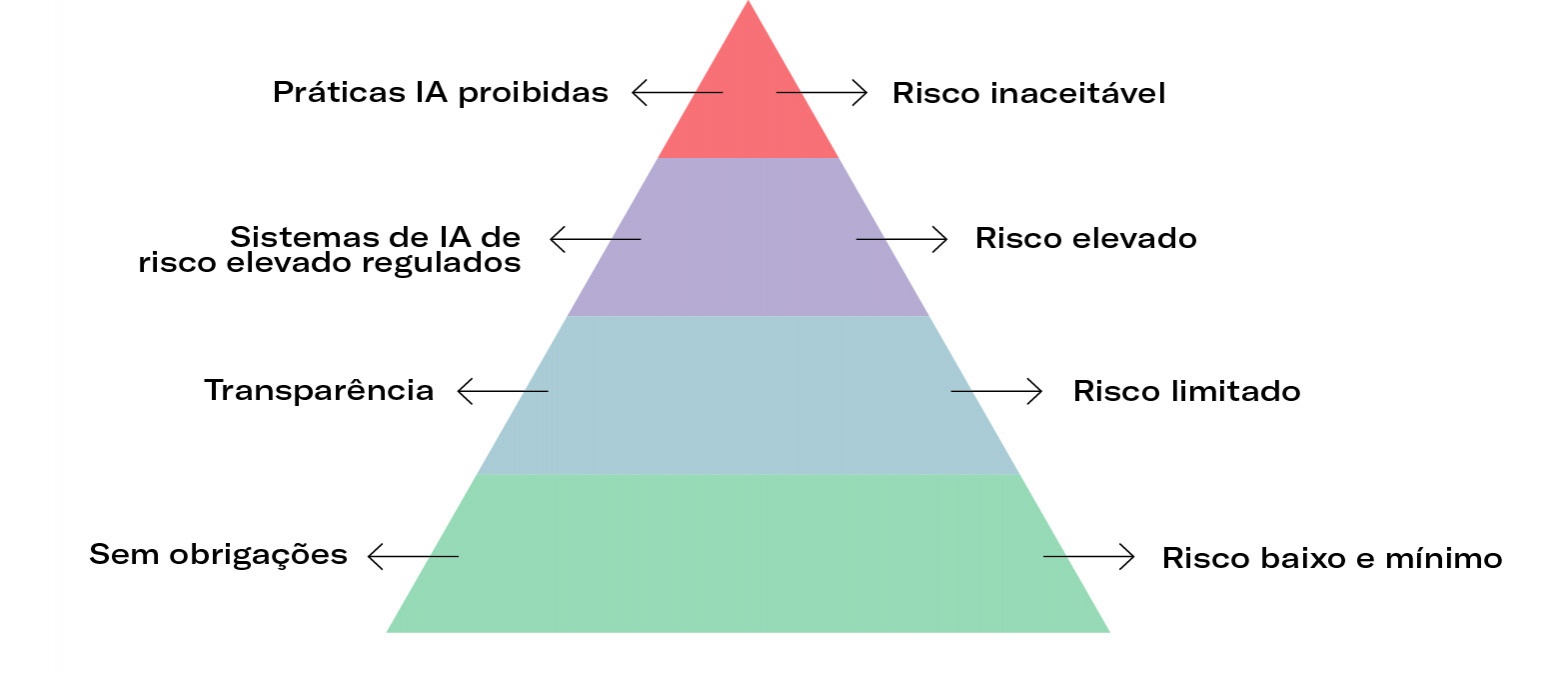

A classificação dos sistemas de IA segue uma abordagem baseada no risco (risk based approach)[2], especialmente no que respeita aos de risco elevado previstos no Capítulo III do AI Act.

A figura abaixo ilustra os vários níveis de classificação de risco, incluindo os sistemas de IA cuja utilização não é permitida por serem consideradas práticas proibidas, nos termos do artigo 5.º do AI Act[3].

A Comissão Europeia deve publicar orientações sobre a aplicação prática deste regulamento, em especial directrizes sobre a classificação de sistemas de IA de risco elevado até fevereiro de 2026.

Fonte: Comissão Europeia

Segundo o AI Act, os sistemas de risco elevado apenas podem ser usados quando não representem riscos inaceitáveis para a saúde, segurança ou direitos fundamentais das pessoas. Estes sistemas dividem-se em:

- Sistemas de IA utilizados como componentes de segurança de produtos ou produtos referidos no anexo I[4] ;

- Sistemas de IA previstos no Anexo III do AI Act que geram riscos significativos para saúde, segurança ou direitos fundamentais[5]. Quando não representem um risco significativo, estes sistemas não são considerados de risco elevado [6].

OBJETIVO DAS ORIENTAÇÕES PROPOSTAS PELA COMISSÃO

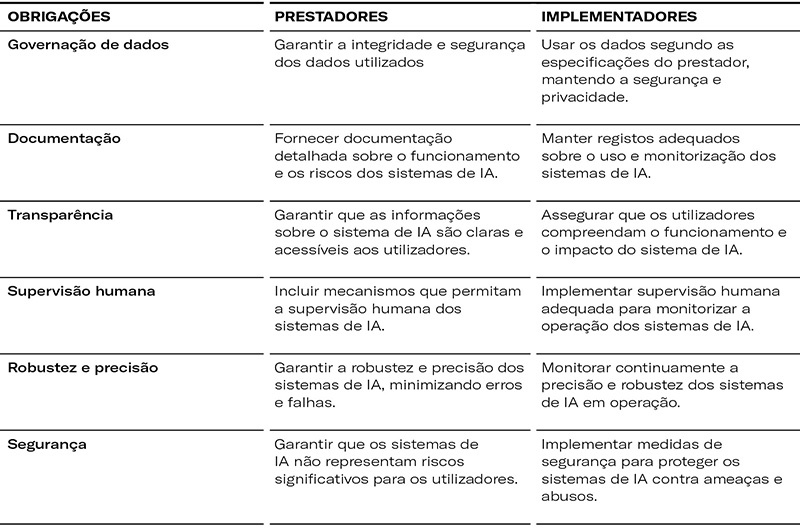

De acordo com o AI Act, a Comissão Europeia deve publicar orientações sobre a aplicação prática deste regulamento, em especial directrizes sobre a classificação de sistemas de IA de risco elevado até fevereiro de 2026[7]. Adicionalmente, a Comissão deve elaborar orientações sobre os requisitos legais e as responsabilidades dos operadores ao longo da cadeia de valor[8]. As Orientações visam:

- Fornecer exemplos práticos e esclarecer questões sobre a classificação de sistemas de IA de risco elevado referidos nos n.ºs 1 e 2 do artigo 6.º e nos anexos I e III do AI Act;

- Ajudar prestadores e implementadores a compreender e cumprir os requisitos e obrigações aplicá - veis aos sistemas de IA de risco elevado, tais como:

A consulta promovida pela Comissão Europeia termina a 18 de julho de 2025 e as Orientações serão publicadas até 2 de fevereiro de 2026. As regras relativas à classificação de sistemas de risco elevado previstas no n.º 1 do artigo 6.º serão aplicáveis a partir de 2 de agosto de 2027.

[2] Ver Considerando 26 do AI Act.

[3] Decorre do Considerando 28 do AI Act que o uso de sistemas de IA para práticas manipuladoras, exploratórias e de controlo social, devem ser proibidos ao abrigo do direito da União porque desrespeitam valores da UE, exceto em situações em que esteja em causa a sua utilização para efeitos de aplicação da lei (como é o caso dos sistemas de identificação biométrica) e o seu uso seja regulamentado de forma exaustiva e restritiva.

[4] Artigo 6.º, n.º 1 do AI Act.

[5] Artigo 6.º, n.º 2 do AI Act.

[6] Artigo 6.º, n.º 3 do AI Act. Este artigo aplica-se a sistemas que desempenham tarefas processuais restritas, melhoram o resultado de uma atividade humana previamente concluída, detetam padrões de tomada de decisões sem substituir ou influenciar significativamente a avaliação humana ou que executam tarefas preparatórias no contexto de avaliações relevantes. Exemplos específicos de sistemas de IA isentos de serem considerados de risco elevado incluem (i) plataformas interativas e tutores virtuais, desde que não manipulem comportamentos ou criem dependência nociva; (ii) robots de apoio a idosos e pessoas com deficiência, que ajudam nas atividades diárias sem substituir a avaliação humana; (iii) ferramentas que auxiliam à integração de indivíduos em novas comunidades ou no mercado de trabalho, sem influenciar significativamente decisões críticas

[7] Artigo 6.º, n.º 5, do AI Act.

[8] Artigo 96.º, n.º 1 alínea a) do AI Act.